Почему не стоит игнорировать файл robots.txt?

Файл robots.txt предназначен для того, чтобы давать ПС информация о том, что можно индексировать на сайте, а что нет. Игнорирование и некорректная настройка данного файла является типичной ошибок многих веб-мастеров, из-за чего их сайты не правильно индексируются, в свободный доступ попадают конфиденциальные данные или же вообще не индексируется и сайт не представлен в выдаче ПС.

Место расположение файла robots.txt – корень сайта, т.е. он должен быть доступен с адреса http://www.site.ru/robots.txt.

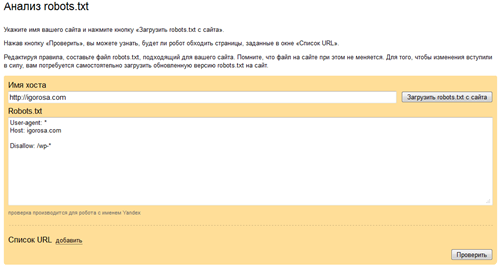

Так же можно воспользоваться сервисом от Яндекс.Вебмастер – http://webmaster.yandex.ua/robots.xml

Чтобы не дать миру узнать о том, что ему не нужно знать, стоит всегда закрывать от индексации:

- административные страницы CMS;

- страницы результатов поиска по сайту;

- страницы с логами сервера;

- сервисные страницы.

С точки зрения SEO закрываем:

- дублирующие страницы (дабы не схватить санкций со стороны ПС);

- любые другие неполезные для пользователя страницы (без контента, в разработке, авторизации, регистрации и т.п.).

Таким образом, что легче было раскрутить сайт самостоятельно, необходимо правильно настроить файл robots.txt, что не просто облегчит вам жизнь, а и упростит продвижение сайта путем удаления ненужных страниц из общей базы ПС, тем самым перераспределив вес остальных (нужных) страниц.